大致的步骤如下:

1)先用25000个prompt利用SD天生约10万张图片,每个prompt天生4张图片,人工标记天生的4张图片和prompt那个最匹配

2)利用上一步天生的图像和prompt输入clip中进行微调,prompt的encoder和匹配的天生图片的encoder特色余弦间隔最小,其他图片阔别

3)利用微调过的clip模型演习天生SD,数据包含标注的天生数据和原始的SD演习数据,同时结合Lora微调

4)标注的不匹配数据在演习时加入罕有词汇进行编码,作为模型的Negative prompt,在推理阶段,利用Negative prompt进行抑制,肃清模型天生的不好数据,这个就像SVDiff里的Cut-Mix用Negative prompt进行抑制,事理是一样的

文章首发微信"大众年夜众号:小小cv条记论文题目

Human Preference Score:Better Aligning Text-to-Image Models with Human Preference

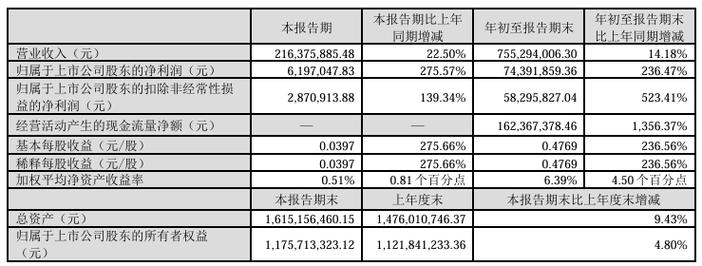

择要

近年来,深度天生模型得到了快速发展,文本到图像模型受到了"大众年夜众的广泛关注。然而,现有的模型常日天生的图像与人类的偏好不太同等,比如肢体和面部表情的尴尬组合。为理解决这个问题,我们从Stable F Discord频道网络了人类对天生图像的选择数据集。我们的实验表明,目前天生模型的评估指标与人类的选择不太干系。因此,我们用网络到的数据集演习一个人类偏好分类器,并基于分类器得出人类偏好评分(HPS)。利用HPS,我们提出了一种大略而有效的方法来适应稳定扩散,以更好地符合人类的偏好。我们的实验表明,HPS在预测人类选择方面优于CLIP,并且对其他模型天生的图像具有良好的泛化能力。通过在HPS的辅导下对Stable Diffusion进行调度,适应后的模型能够天生人类用户更喜好的图像。

1. 先容

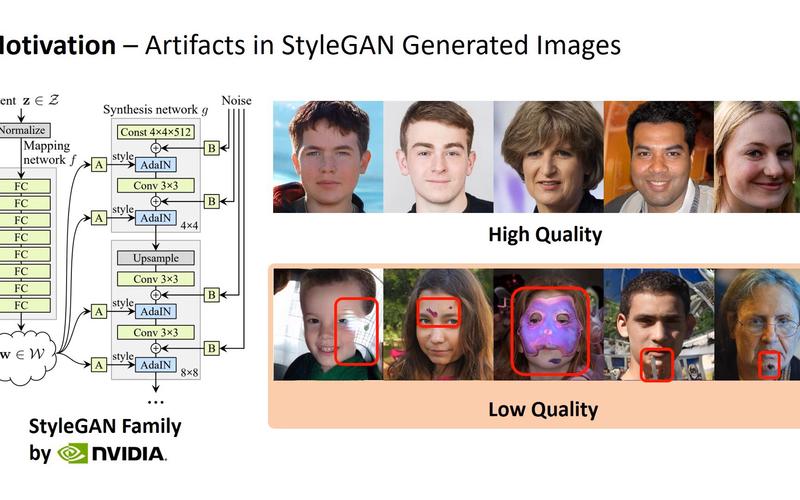

扩散模型的最新进展[26,30,35,32]使文本到图像的天生取得了令人印象深刻的进步,许多模型现在被支配在现实天下的运用中,如DALL·E[30]和Stable diffusion[32]。然而,"大众年夜众的关注也突出了一些新的问题,例如如图1所示的天生人的肢体和面部表情的尴尬组合。

用户常日须要精心挑选结果以避免这些工件。换句话说,天生的图像与人类的偏好不一致。为了进一步提高天生图像的质量,必须跟踪模型天生人类优选图像的能力。然而,目前尚不愿定现有的评估指标,如Inception Score (is)[36]和fr起始间隔(FID)[13]是否与人类的选择干系。这些指标通过在ImageNet上演习的基于分类的CNN来感知图像[34],这已经被证明倾向于图像纹理而不是一样平常的图像内容[10],因此可能与人类的感知不太同等。此外,IS和FID都是单模态评估指标,没有考虑到用户的意图。最近的一些研究[26,30,3]利用CLIP[29]模型作为人类判断的代理来评估天生的图像和文本提示之间的对齐情形。CLIP[29]模型是在一个丰富的数据集上演习的,被认为能更好地捕捉人类意图的奇妙方面。然而,CLIP[29]是否能够衡量天生的合成图像的质量是不愿定的,合成图像可能不遵照与真实图像相同的约束条件,例如图1所示的示例。

在这项研究中,我们利用一个新的、大规模的人类选择数据集来研究人类偏好问题,该数据集是由Stable Diffusion[32]利用相同的提示天生的图像。该数据集包括98,807张不同的图像,这些图像是由用户供应的提示天生的,还有25,205张人工选择的图像。通过对该数据集的评估,我们创造Inception Score, IS[36]、fr Inception间隔(FID)[13]和CLIP评分与人类的选择并不完备匹配,这意味着人类的偏好是图像质量缺失落的一个维度,现有的主流指标无法很好地跟踪这一维度。我们通过微调CLIP[29]模型,在该数据集上进一步演习人类偏好分类器,并在此根本上定义人类偏好评分(HPS)。我们通过用户研究验证了HPS与人类选择的同等性及其对其他天生模型的泛化能力。

HPS可以用来辅导天生模型产生人类偏好的图像。为此,我们设计了一种大略而有效的方法,通过LoRA[17]来适应人类偏好的稳定扩散[32]。我们进行用户研究来验证我们方法的有效性。结果表明,调度后的模型可以更好地捕捉人类的意图,并天生更空想的图像,这大大减轻了图1中所示的那种伪影。

我们的贡献如下:

(1)我们创建了一个大规模的数据集来研究人类的偏好。据我们所知,这个数据集是同类中第一个在相同提示下天生的图像上包含大量人类选择的数据集。

(2)我们创造,现有的主流评价指标无法准确预测人类的选择,而通过对所提出的数据集进行微调的CLIP可以更好地预测人类的选择。

(3)我们提出了一种大略而有效的方法来勾引稳定扩散模型天生具有更好美学质量和更符合人类意图的图像。

2. 干系的事情

文本到图像天生模型。文本到图像的天生模型一贯是一个生动的研究领域。Mansimov等人[23]表明,Deep Recurrent Attention Writer (DRAW)[11]可以根据标题天生新的场景构图。天生对抗网络(GANs)通过演习一个判别器来为天生模型供应监督,从而提高图像保真度。

DALL·E[31]首先利用大量的图像-文本对实现了开放域的文本-图像合成。扩散模型将天生过程表述为扩散过程的逆过程[41],Song和Ermon[42]以及Ho等人[15]对此进行了改进。Dhariwal等人首先证明了扩散模型在图像天生方面优于gan。随后的几部作品,包括DALL·e2[30]、GLIDE[26]、Imagen[35]、ERNIEViLG[9,47]、Stable Diffusion[32],将文本-图像天生的魔力带入了"大众年夜众的视野。在这些模型中,Stable Diffusion是一个拥有生动用户社区的开源模型。

最近的几项研究在不同方面改进了稳定扩散。DreamBooth[33]和ELITE[46]探索为特定工具定制稳定扩散。Feng等人[8]提出了一种无需演习的方法来辅导扩散模型,以得到更好的组成能力。提示工程在天生高质量图像中起着重要的浸染。Hao等[12]通过强化学习设计了一种自动提示工程方案。我们的方法侧重于天生的图像与人类偏好之间的不对齐,这与上述主题是正交的。

天生图像的数据集。天生图像的数据集在难以获取地真值的打算机视觉任务中发挥着至关主要的浸染,例如光流估计[24,7,4,44,18,39,40]。由于文本到图像模型的生动用户社区,已经引入了几个由扩散模型天生的图像数据库。

Lexica (Lexica .art)是一个由Stable Diffusion和Lexica Aperture天生的大型图像数据库。它还供应了图像的干系信息,如提示和勾引规模。然而,该数据库是闭源的,只许可在线浏览。DiffusionDB[45]是一个从Stable Foundation Discord频道网络的大型开源数据库,包含每张图像的文本提示符和参数。SAC[28]是由Stable Diffusion和GLIDE[26]天生的图像数据集,以及来自美学调查的用户评分。然而,与我们的数据集比较,SAC只包含有限的用户选择。

从人的反馈中学习。长期以来,人类反馈被广泛运用于深度学习任务。Christiano等[6]和Arakawa等[1]将人的反馈纳入强化学习演习,这被证明可以加速模型的收敛。Krishna等[20]提出“社交情境人工智能”,通过在Instagram上与人类用户互动,显著提高了图像识别性能。InstructGPT[27]通过基于人类反馈演习的褒奖函数对GPT进行微调,为ChatGPT的成功奠定了根本。[12]和[21]利用类似的方法来改进文本到图像的模型,这与我们的事情高度干系。在[12]中,这是通过增加文本提示符来实现的。[21]是一项同时进行的事情,更多地关注文本和图像之间的精确对齐,而我们的事情表明,当反馈考虑到人类的审美偏好时,人类反馈的潜力远远超出了精确对齐。

3. 人类偏好数据集

为了更好地理解人类对由提示天生的图像的偏好,并提高文本到图像天生的质量,我们首先网络人类选择的数据集。

数据网络。我们利用Stable Foundation Discord做事器上的“dreambot”频道网络人类选择数据。这些频道的谈天历史记录是利用discordchatexporters[16]工具得到的,该工具下载了一个Discord频道的完全谈天历史记录,并以JSON格式存储。在谈天中,可以不雅观察到一种可识别的交互模式,如图4所示,它揭示了人类的偏好。在此模式中,用户通过向bot发送文本提示来启动会话,bot会天生几个图像作为相应。然后,用户选择首选图像并将其连同原始文本提示一起发送回机器人。机器人将返回几张风雅的图像。交互遵照预定义的语法,它许可我们利用大略的模式匹配技能提取人类选择和干系图像。

数据格式和统计。末了,我们得到了由25,205个提示天生的统共98,807个图像。每个提示符对应几张图片,个中一张图片被用户选择为首选图片,而其他图片则是非首选的负面图片。每个提示符对应不同数量的图像。23,722个提示有四个图像,953个提示有三个图像,530个提示有两个图像。每个提示符的图像数量取决于用户在天生要求中的规格。值得把稳的是,数据集显示出高度的多样性,图像天生的主题范围很广。该数据集由2,659个不同用户的选择组成,每个用户最多贡献267个选择。网络到的数据集示例如图3所示。有关数据集的更多细节,我们请读者参阅附录中的图9。

隐私和NSFW内容。我们不雅观察到一小部分图像是带有图像条件天生的(该条件图像可以由用户天生或上传)。由于用户上传的图像可能包含敏感信息或隐私,因此我们不将其包含在我们的数据集中。对付含有潜在NSFW内容的图像,我们利用通道机器人的NSFW检测器将其过滤掉。

在这项事情中,我们利用该数据集来研究现有指标与人类偏好的干系性,这将在第4节中先容。该数据集还用作我们的人类偏好分类器的演习数据,这将在第5节中先容。

4. 现有的指标

在本节中,我们展示了当前主流的评估指标与我们数据集上的人类偏好没有很好的干系性。

4.1. 由Inception Net供应的度量

Inception Score (IS)[36]和fr起始间隔(FID)[13]是评估天生图像质量的两个常用指标。它们都通过在ImageNet[34]上演习的inception[43]来感知图像。在本节中,我们将研究它们与人类选择的干系性。

Inception Score (IS)通过打算所有天生图像的边缘种别分布和特定天生图像的条件分布之间的期望kl -散度来衡量天生图像的质量,利用由Inception Net预测的种别概率。这个度量被期望捕获天生图像的保真度和多样性。为了确定IS与人类偏好之间的干系性,我们打算了数据集中首选和非首选图像集的IS。对付每种设置,我们将20,000张图像分成10组,并报告在它们上打算的IS的均匀值和标准差。我们的结果如表1所示,首选图像和非首选图像之间没有显著差异。

初始间隔(FID)衡量天生图像的嵌入特色与真实图像的相似度。这是通过将嵌入特色拟合到多元高斯分布中并打算它们的间隔来实现的。为了定义目标分布,FID须要一组真实图像。然而,对付由用户供应的提示天生的图像,例如在我们的数据集中,目标分布是由用户的意图定义的,而用户的意图只能从文本提示中推断出来。为理解决这个问题,我们从我们的数据集中随机抽取了10,000个文本提示,对付每个提示,我们通过官方api查询LAION[38]数据集,以找到最靠近的图像,这被视为该提示的“伪根本事实”。这供应了一组与用户意图同等的真实图像。我们从网络的数据集的首选和非首选分割中随机抽取10,000张图像,以利用真实图像打算FID。我们的结果如表1所示,首选图像和非首选图像在FID方面没有显著差异。这表明FID可能不是评估人类偏好的可靠指标。

谈论。在评估人类偏好时,IS和FID可能会碰着以下三个问题。首先,天生的图像常日包含形状伪影,如图1所示。然而,基于分类的cnn每每倾向于图像纹理而不是形状[10],这使得它们很可能忽略天生图像中的形状伪影。此外,领域差距也会带来问题。虽然评估模型是在ImageNet[34]的真实图像上进行演习的,但我们数据集中天生的图像展示了广泛的风格和主题,从油画肖像到电子人的数字艺术。因此,imagenet演习的模型可能对这些不同的图像没有故意义的表示[2]。此外,这些指标受其单模态特性的限定,这意味着它们不能通过访问提示来推断用户的意图,除非目标图像是已知的或像我们一样供应的。

4.2. CLIP指标

得益于弘大而多样的演习数据集,与imagenet演习的模型比较,CLIP在编码来自不同领域的图像方面做得更好。此外,它可以通过编码文本提示来捕捉用户的意图,使其成为评估提示与天生图像之间对齐的合理选择[26,30,3,32]。Aesthetic Score Predictor[37]是另一个基于clip的图像质量评估工具,它被用来过滤Stable Diffusion的演习数据[32]。在本节中,我们将评估这些工具在预测人类行为方面的能力选择,这是通过打算人类选择预测任务的准确性来完成的,该任务是在我们数据集中的5000个样本中进行的。

CLIP分数是由CLIP打算的提示嵌入和图像嵌入之间的余弦相似度推导出来的。我们评估了ViT-L/14和RN50x64模型的性能,这是变压器和CNN架构中最大的开源CLIP模型。我们的结果如表2所示,表明两种CLIP模型都比随机预测表现出更好的性能。然而,我们将在7.1节中展示CLIP分数与人类选择的关系并不好。只管如此,我们还将展示它可以在我们的数据集上进一步微调,以更好地与人类偏好保持同等。

美学评分基于预演习的vit - l /14 CLIP图像编码器,该编码器通过在CLIP图像编码器上添加MLP层来适应美学评分预测的任务。MLP在几个美学数据集上进行演习,包括真实图像和天生的图像(例如,AVA [25], SAC[28]),以预测从1到10的美学分数。与CLIP不同,美学分类器不以提示为条件,因此将预测分数最高的图像作为模型选择。如表2所示,美学分类器在预测用户选择方面也表现出优于机会的准确性,这表明图像的美学方面在人类决策中的主要性。

5. Human Preference Score

我们首先演习一个人类偏好分类器来根据提示预测人类的选择,然后基于演习好的分类器推导出HPS。

人类偏好分类器我们对数据集上的vit - l /14版本的CLIP进行了微调,以更好地与人类偏好保持同等。演习集中的每个样本包含一个提示符和n∈{2,3,4}图像,个中只有一个图像是用户首选的。对该模型进行演习,使CLIP文本编码器打算的文本提示嵌入与CLIP视觉编码器打算的首选图像嵌入之间的相似性最大化,同时使非首选图像的相似性最小化。通过微调人类对天生图像的选择,该模型被鼓励更好地与人类偏好保持同等。

人类偏好评分(HPS)是由人类偏好分类器衍生而来的。我们将HPS定义为:

个中encv和enct是人类偏好分类器的视觉编码器和文本编码器。为了更好地可视化,我们将余弦相似度乘以100倍。

6. 更好地将稳定扩散与HPS结合起来

HPS可用于辅导基于扩散的天生模型,以更好地与人类用户保持同等。我们认为,天生的图像与人类偏好之间的不一致是一个缺失落“意识”的问题,而不是模型能力的问题。为理解决这个问题,我们建议通过明确区分首选图像和非首选图像来调度天生模型。我们的办理方案大略直不雅观。我们构建了另一个由提示及其新天生的图像组成的数据集,我们利用之前演习过的人类偏好分类器将其分类为首选或非首选。对付非首选图像,我们通过添加分外前缀来修正其相应的提示符。通过LoRA在该数据集上适应Stable Diffusion[17],我们增强了模型学习非首选图像观点的能力,随后在推理过程中可以避免非首选图像。

构建演习数据。我们从DiffusionDB[45]的“前1m”分割中构建演习数据,并从Stable Diffusion (LAION-5B)的预演习数据集中提取子集进行正则化。DiffusionDB[45]是天生图像及其文本提示的大规模数据集。对付来自DiffusionDB的图像,我们首先打算每个图像提示对的HPS。之后,我们根据提示对图像进行分组,对付每个提示T,如果符合以下条件,我们将具有最高HPS的图像I 添加到演习数据中:

个中n是具有相同提示符的图像数量,α是掌握选择性的超参数。P为:

个中B为具有相同提示符的图像凑集。类似地,我们用相同的标准布局非首选子集,但利用负HPS。末了,我们得到了天生图像和真实图像的稠浊数据集,个中非首选天生图像通过其提示前缀进行识别。

适应稳定扩散。我们采取LoRA[17]将Stable Diffusion运用到演习数据中,保持原始模型的参数不变,并对{key, query, value, out}投影矩阵进行低秩残差增广。LoRA不向模型添加新的参数,由于学习到的投影矩阵一旦演习就可以合并到基本模型中。在演习期间,我们利用提示符作为天生图像的标题。对付非首选图像,我们在每个标题前添加一个分外标识符(我们选择“奇怪的图像”)。作为我们的分外标识符)。在推理过程中,分外标识符被用作无分类器勾引的负提示符[14],以避免产生非首选图像。

7. 实验

在本节中,我们首先在7.1节中验证了HPS的可靠性,然后在7.2节中先容了我们自适应稳定扩散的实验。

7.1. HPS

HPS分类器的实现细节。我们在演习过程中利用了数据集中的20,205个样本,个中包含20,205个提示和79,167张图像。我们在实验中利用的是ViT-L/14版本的CLIP。我们对CLIP图像编码器的末了10层和文本编码器的末了6层进行微调。模型由AdamW优化器[19]演习,1 epoch的学习率为1.7 × 10−5。批量大小为5。学习率随余弦学习率操持而衰减。权重衰减设为3.1 × 10−3。我们不该用随机调度裁剪的原始数据增强,而是直接将图像的最长边缘调度为224,然后添补零使较短的边缘增加为224。我们的履历创造,固定图像的长宽比是有益的。超参数通过贝叶斯优化进行调度。

与人类对齐。如表2所示,演习后的模型在人类选择预测任务中显著优于CLIP。由于人类偏好的强烈多样性,其准确性乃至高于我们的人类参与者。

泛化。我们通过用户研究来评估HPS对其他天生模型的泛化能力。在这个实验中,我们让人类偏好分类器和几个人类参与者评估了398对图像。每对图像由DALL·E[30]和Stable Diffusion[32]天生,文本提示相同。提示是随机从DiffusionDB[45]中抽取的,DiffusionDB是一个大型的图像和提示数据库,来自Stable Foundation Discord频道。我们通过DiffusionDB[45]中供应的指标过滤掉NSFW提示。

在表3中,我们评估了人类、CLIP和HPS预测之间的同等性。该协议是通过均匀每个参与者的预测相似度来打算的。与CLIP比较,HPS更符合人类偏好,其与人类的同等性靠近于人类之间的同等性。结果表明,HPS可以泛化到其他模型天生的图像。我们建议读者参阅补充材料,以得到本用户研究中所做的图像和选择的完全列表。

与CLIP评分的干系性。在图6中,我们可视化了HPS和CLIP评分之间的干系性。文本提示从COCO Captions[5]数据集中随机采样,图像由Stable Diffusion[32]天生。我们可以看到,HPS与CLIP评分呈正干系,但更强调图像的审美质量。然而,HPS对图像内容与文本提示的直接匹配重视程度较低,这可以理解为引入“对齐税”的视觉类比

7.2. 更好地将稳定扩散与HPS结合起来

实现细节。我们利用Stable Diffusion [32] v1.4进行所有实验。在布局演习集时,首选图像和非首选图像的α值都设置为2.0。构建的演习集包含37,572个首选天生图像和21,108个非首选天生图像。正则化图像来自LAION-5B的625k子集,由美学评分预测器过滤,阈值为6.5。200,231张正则化图像参与演习。我们只微调稳定扩散的UNet,同时保持VAE和文本编码器在演习期间冻结。在LoRA中,rank设置为32[17]。利用AdamW[19]优化器对LoRA权值进行10k次迭代演习,学习率为1 × 10−5,权值衰减为1 × 10−2,在演习过程中保持恒定。我们在实验中利用了40个批次。对付推理,我们利用PNDM[22]噪音调剂器对每个图像运行50步扩散过程。对付无分类器的制导,我们利用默认的7.5的制导尺度[14]。

人类的评价。通过用户研究,我们将演习好的模型与原始的Stable Diffusion进行比较。在本研究中,我们从DiffusionDB[45]中随机抽取100个用户供应的提示。对付每个提示,我们利用相同的随机种子从两个模型中天生一个图像,以进行公正的比较,从而天生100对用于用户研究的图像。我们让20名参与者阅读提示,然后根据他们的偏好在我们演习模型天生的图像和原始的Stable Diffusion之间进行选择。在图3中,我们通过显示具有不同正面票数的图像的百分最近可视化我们的结果。调度后的模型明显优于原模型。改编模型天生的图像中,有74%的图像得到了超过10票,而原始模型的这一数字为22%。用户学习界面的截图见附录中的图12。

定性评估。在图7中,我们展示了一些范例的改进案例。我们比较了原始模型、纯洁则化模型和自适应模型。该模型同时利用真实正则化图像和天生的带有HPS偏好标签的图像进行演习。仅正则化模型是与自适应模型进行正面比较,自适应模型通过从演习集中删除天生的图像进行演习,并且只对正则化图像进行相同步数的演习。结果表明,调度后的模型可以更好地从提示中捕捉用户意图,如图1所示。末了三行显示,用天生的图像进行演习,减轻了肢体不自然的问题。更多的例子请参阅附录中的图7和图10。

定量评价。在表4中,我们将调度后的模型与FID、美学评分、CLIP评分和HPS的基线进行了比较。FID[13]是在来自LAION[38]数据集的10k张图像上打算的。CLIP Score[29]和HPS是根据DiffusionDB[45]的提示打算的。

8 局限性

这个数据集有几个限定。网络的数据集包含天生的提示和"大众年夜世人物的图像。我们选择将它们标记出来,而不是删除它们,以保持数据集的多样性。只管数据集的多样性,我们也意识到它只代表了天下上一小部分人的偏好,并且它可能倾向于在稳定基金会不和谐频道中生动的特定人群。关于该数据集的另一个潜在偏差是,大部分文本提示都是由履历丰富的Stable Diffusion用户编写的。这些提示很可能被调度,以激活稳定扩散的潜力,偏离正常的措辞习气。

9. 结论

在这项事情中,我们在天生的图像的大规模数据集上研究人类偏好。我们创造以前的天生模型的评估指标与人类的偏好不太同等,但是CLIP模型可以被微调成人类偏好分类器,以更好地与人类的选择保持同等。然后,我们展示了一种大略而有效的方法,使天生模型在人类偏好分数的辅导下天生更优的图像。我们希望我们的事情能够勉励社区探索人类人工智能研究的新可能性。